Del código a la norma: “algorética” y lenguaje jurídico en la era de la inteligencia artificial

"La educación jurídica y tecnológica, una necesidad urgente"

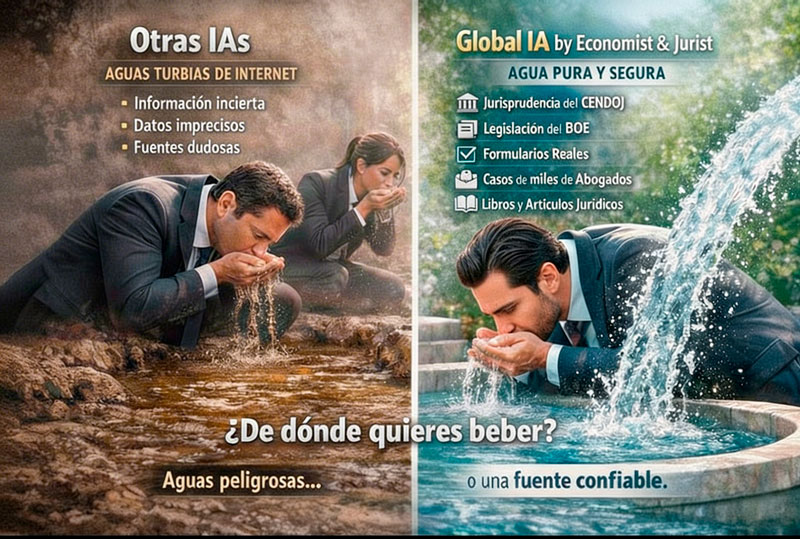

(Imagen: E&J)

Del código a la norma: “algorética” y lenguaje jurídico en la era de la inteligencia artificial

"La educación jurídica y tecnológica, una necesidad urgente"

(Imagen: E&J)

La inteligencia artificial (en adelante, “IA”) ha dejado de ser un fenómeno futurista para convertirse en protagonista esencial de nuestra realidad social, económica y jurídica. Hoy, algoritmos predictivos, modelos generativos y sistemas automatizados toman decisiones que antes eran dominio exclusivo de personas. En este nuevo contexto, la tradicional función del Derecho de regular la conducta humana se enfrenta al desafío inédito de gobernar entidades algorítmicas cuya lógica, basada en datos y código, desafía la interpretación flexible y abierta del lenguaje jurídico.

Surge así la «algorética», un término acuñado por el teólogo y científico italiano Paolo Benanti que designa la incorporación consciente de valores éticos como la transparencia, equidad, responsabilidad y dignidad humana dentro del propio desarrollo tecnológico. Su propósito fundamental es asegurar que los algoritmos no solo sean eficientes y precisos, sino también justos y respetuosos con los derechos fundamentales.

Sin embargo, la efectividad de estos principios éticos depende de la capacidad del lenguaje jurídico para convertirlos en normas claras y exigibles. Este proceso implica superar la tensión intrínseca entre el carácter flexible del Derecho y la rigidez formal del código informático.

...

Suscríbete a nuestra

NEWSLETTER