Open AI ante su, previsible levantamiento del velo fáustico a lo Dorian Gray

Implicaciones jurídicas del inminente advenimiento de la publicidad en ChatGPT. ¿Neutralidad y "democratización del conocimiento"? ¡Ja!

(Imagen: Pablo Sáez Hurtado)

Open AI ante su, previsible levantamiento del velo fáustico a lo Dorian Gray

Implicaciones jurídicas del inminente advenimiento de la publicidad en ChatGPT. ¿Neutralidad y "democratización del conocimiento"? ¡Ja!

(Imagen: Pablo Sáez Hurtado)

Introducción: el pacto fáustico de Silicon Valley

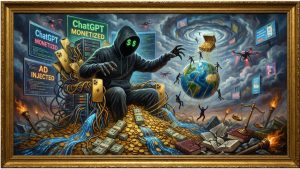

En la célebre novela de Oscar Wilde, Dorian Gray conserva su juventud y belleza mientras un retrato oculto envejece y se corrompe, absorbiendo la depravación moral de su vida. La historia de OpenAI y su creación estrella, ChatGPT, parece seguir una parábola similar. Lanzado al mundo el 30 de noviembre de 2022, este modelo lingüístico se presentó como un avance sin precedentes hacia la «democratización del conocimiento», una herramienta neutral y accesible destinada a beneficiar a toda la humanidad. Su rostro público era el de la innovación altruista, un asistente conversacional casi omnisciente, pulcro y objetivo. Sin embargo, en las sombras, el retrato de su modelo de negocio comenzaba a acumular las cicatrices de la realidad económica de Silicon Valley.

El 16 de enero de 2026, OpenAI desveló finalmente el retrato. Con un comunicado titulado «Nuestro enfoque sobre la publicidad y la expansión del acceso a ChatGPT» [1], la compañía anunció el inicio de pruebas para introducir anuncios en las versiones gratuitas y de bajo coste de su chatbot. La justificación, predecible y mil veces escuchada, era la de «expandir el acceso asequible a la IA en todo el mundo». Pero el velo fáustico se había levantado. El pacto, sellado en silencio mucho antes, se hacía visible: para sostener los colosales costes operativos de una inteligencia artificial cada vez más potente, era necesario recurrir al motor económico por antonomasia de la internet moderna: la publicidad.

Este movimiento, aunque esperado por los analistas más escépticos, representa un punto de inflexión crítico no solo para el futuro de OpenAI, sino para el ecosistema de la inteligencia artificial generativa en su conjunto. La entrada de la publicidad en el corazón de las interacciones conversacionales con una IA de propósito general plantea un aluvión de interrogantes jurídicos de una complejidad extraordinaria. ¿Puede una herramienta que se postula como fuente de conocimiento objetivo mantener su neutralidad cuando sus respuestas pueden estar, directa o indirectamente, influenciadas por intereses comerciales? ¿Cómo se protege al consumidor de formas de publicidad encubierta, manipulación subliminal o explotación de vulnerabilidades conversacionales, cuando el propio medio es un sistema diseñado para generar confianza y emular la interacción humana?

El presente artículo se propone desgranar las profundas implicaciones jurídicas de esta decisión, analizando el encaje de la publicidad en ChatGPT dentro del denso entramado normativo español y europeo. Se abordará desde la óptica de la publicidad tradicional, la competencia desleal y la protección de los consumidores, hasta las nuevas y específicas regulaciones diseñadas para la era digital, como el Reglamento de Servicios Digitales (DSA) y el trascendental Reglamento de Inteligencia Artificial (AI Act). El análisis no se detendrá en la superficie de las declaraciones de intenciones de OpenAI, sino que buscará, precisamente, examinar el «retrato oculto»: las zonas grises, los conflictos normativos y los riesgos sistémicos que emergen cuando un modelo de negocio publicitario se fusiona con una de las tecnologías más influyentes de nuestro tiempo. La pregunta fundamental que subyace es si la promesa de una IA democratizadora puede sobrevivir a su inevitable comercialización o si, como Dorian Gray, su hermoso rostro público está condenado a coexistir con una realidad mucho más oscura y mercantilizada. ¡La respuesta, como veremos, es un rotundo “Ja!».

Suscríbete a nuestra

NEWSLETTER

Crónica de una mentira anunciada: de la filantropía al lucro

La metamorfosis de OpenAI desde una organización sin ánimo de lucro dedicada a la investigación altruista hasta una corporación que abraza el modelo publicitario no es un accidente, sino la consecuencia lógica de una serie de decisiones estratégicas que revelan una calculada ambigüedad en su misión. Fundada en 2015 con el noble propósito de asegurar que la inteligencia artificial general (AGI) beneficiase a toda la humanidad, la organización pronto se encontró con una barrera infranqueable: el desorbitado coste computacional que exigía su propia ambición. La pureza de la misión original comenzó a desvanecerse en 2019, cuando se creó OpenAI LP, una entidad con fines de lucro «limitado» (capped-profit), diseñada para atraer las ingentes inversiones necesarias para seguir compitiendo. Fue el primer y más significativo sacrificio en el altar del pragmatismo económico, un movimiento que sentó las bases para la eventual capitulación ante el modelo publicitario.

Este giro estratégico permitió a OpenAI explotar, con una destreza que roza el fraude de ley, las ambigüedades de la normativa de derechos de autor. La Directiva (UE) 2019/790 sobre los derechos de autor en el mercado único digital, por ejemplo, establece en su artículo 4 una excepción para la minería de textos y datos con fines de investigación científica. OpenAI, amparándose en su origen no lucrativo, ha utilizado esta excepción para entrenar sus modelos con un volumen masivo de datos protegidos, sin obtener licencias ni remunerar a los titulares de los derechos. Sin embargo, el carácter comercial de sus productos más avanzados, como ChatGPT Plus, y ahora la introducción de la publicidad, despojan a la compañía de la legitimidad para acogerse a dicha excepción. La investigación científica ha dado paso a un producto comercial que compite directamente en el mercado, lo que convierte su uso de datos en una apropiación indebida a gran escala, un pecado original sobre el que se ha construido su aparente ventaja tecnológica.

La introducción de ChatGPT Plus en febrero de 2023, apenas tres meses después del lanzamiento de la versión gratuita, fue la primera señal inequívoca de que el modelo de negocio se inclinaba hacia la monetización directa. Por 20 dólares al mes, los usuarios obtenían acceso prioritario y a modelos más avanzados como GPT-4, lanzado en marzo de 2023. Este modelo freemium, si bien legítimo, agrietó la narrativa de la «democratización del conocimiento», creando una brecha entre quienes podían pagar por una IA superior y quienes se conformaban con la versión gratuita, más limitada y propensa a la congestión.

El conflicto latente entre la misión original y la nueva realidad comercial estalló de forma dramática en noviembre de 2023 con la abrupta destitución y posterior readmisión de su CEO, Sam Altman. Aunque las razones oficiales se envolvieron en un velo de opacidad —el consejo de administración alegó que Altman «no había sido consistentemente sincero en sus comunicaciones»—, el trasfondo del conflicto apuntaba a una lucha de poder entre dos facciones: una, más purista y preocupada por los riesgos existenciales de una IA descontrolada, y otra, liderada por Altman, enfocada en un desarrollo y comercialización acelerados. La victoria de Altman, que regresó al poder con un nuevo consejo de administración más afín a sus intereses comerciales y con el respaldo crucial de su principal inversor, Microsoft, selló el destino de la compañía. La filantropía había perdido la batalla; el lucro se había impuesto.

Las declaraciones del propio Altman sobre la publicidad son un testimonio de esta evolución. En mayo de 2024, en una charla en la Universidad de Harvard, calificó el modelo publicitario como un «último recurso» [2]. Apenas unos meses después, su postura se había suavizado, admitiendo que no estaba «totalmente en contra». Estas declaraciones, a la luz del anuncio de enero de 2026, no parecen ahora vacilaciones, sino una cuidada estrategia de comunicación para preparar al público para lo inevitable. La realidad financiera de la compañía era insostenible. Con pérdidas reportadas de más de 8.000 millones de dólares en 2025 y una proyección de 14.000 millones para 2026 [3], la necesidad de una nueva y masiva fuente de ingresos era perentoria. La publicidad no era un «último recurso», sino el siguiente paso lógico en una hoja de ruta escrita mucho antes. El retrato de Dorian Gray, oculto en los libros de contabilidad, se había vuelto demasiado monstruoso para permanecer escondido.

(Imagen: Pablo Sáez Hurtado)

El anuncio del 16 de enero de 2026: anatomía de una capitulación

El comunicado del 16 de enero de 2026, firmado por Fidji Simo —una ejecutiva con una larga trayectoria en monetización y crecimiento, fichada desde Instacart y Facebook—, es una pieza maestra de la comunicación corporativa, diseñada para endulzar una píldora amarga. Bajo el epígrafe «Nuestro enfoque sobre la publicidad y la expansión del acceso a ChatGPT», OpenAI oficializó su rendición al modelo de negocio que había jurado evitar. La capitulación se presentó, no como una necesidad económica, sino como un acto de generosidad: la publicidad era el vehículo para «que más personas puedan beneficiarse de nuestras herramientas con menos límites de uso o sin tener que pagar» [1].

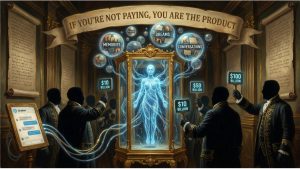

La anatomía del anuncio revela una estrategia de segmentación calculada. Los anuncios se probarían inicialmente en Estados Unidos, limitados a los usuarios de la versión gratuita y del recién expandido plan de bajo coste, «ChatGPT Go», ofrecido por 8 dólares al mes. Los suscriptores de los planes más caros (Plus, Pro, Business y Enterprise) quedarían, por ahora, exentos. Este movimiento crea una clara jerarquía de usuarios: aquellos que pagan por una experiencia «pura» y sin anuncios, y aquellos cuya atención se convierte en la moneda de cambio para acceder a la tecnología. La democratización del conocimiento se revela, así como una democratización del acceso al producto, donde el usuario gratuito pasa a ser, él mismo, el producto que se vende a los anunciantes.

Para mitigar las previsibles críticas, OpenAI se apresuró a establecer una serie de «principios» que, supuestamente, guiarían su incursión en el mercado publicitario. Prometieron «independencia de las respuestas», asegurando que los anuncios no influirían en el contenido orgánico del chatbot y que siempre estarían «claramente etiquetados y separados». Proclamaron la «privacidad de las conversaciones», afirmando que no venderían datos a los anunciantes. Y garantizaron «elección y control», permitiendo a los usuarios desactivar la personalización. Sin embargo, estos principios, aunque loables en su formulación, están plagados de ambigüedades y desafíos prácticos que serán analizados en detalle más adelante. La promesa de separar el contenido editorial del publicitario en un entorno conversacional, donde la línea entre una recomendación útil y un anuncio encubierto es intrínsecamente difusa, es, como mínimo, optimista.

La elección de Fidji Simo como portavoz del anuncio no es casual. Su perfil, alejado del núcleo de investigación en IA y centrado en el crecimiento de plataformas y la monetización, simboliza el cambio de paradigma en OpenAI. La empresa ya no se define únicamente por sus avances tecnológicos, sino por su capacidad para construir un negocio sostenible. La publicidad, en este nuevo marco, no es una traición a la misión, sino la culminación de su estrategia de negocio. La capitulación era, en realidad, una declaración de intenciones: OpenAI había completado su transición de laboratorio de investigación a gigante tecnológico, con todas las implicaciones comerciales y jurídicas que ello conlleva.

Marco jurídico español aplicable a la publicidad en ChatGPT

La introducción de publicidad en una herramienta como ChatGPT obliga a un análisis minucioso de su encaje en el ordenamiento jurídico español, un marco garantista diseñado en gran medida antes de la eclosión de la inteligencia artificial conversacional. La colisión entre una tecnología disruptiva y un cuerpo normativo consolidado genera una tensión que se manifiesta en múltiples frentes, desde la publicidad y la competencia hasta la protección de los consumidores y sus datos personales.

Ley 34/1988, de 11 de noviembre, General de Publicidad (LGP)

La LGP constituye la piedra angular de la regulación publicitaria en España. Su artículo 2 define la publicidad como «toda forma de comunicación realizada por una persona física o jurídica, pública o privada, en el ejercicio de una actividad comercial, industrial, artesanal o profesional, con el fin de promover de forma directa o indirecta la contratación de bienes muebles o inmuebles, servicios, derechos y obligaciones». Las respuestas de ChatGPT que contengan mensajes promocionales, ya sea de forma explícita o sutil, encajan sin dificultad en esta definición, y OpenAI, como entidad que gestiona el medio, ostenta la condición de «agencia de publicidad» o «medio de difusión».

El principal desafío que plantea ChatGPT a la LGP reside en el principio de identificación, recogido en su artículo 9, que exige que la publicidad sea claramente reconocible como tal. En un medio conversacional, donde la naturalidad y la fluidez del lenguaje son clave, la tentación de integrar la publicidad de forma orgánica en las respuestas es enorme. Una línea de texto que indique «patrocinado» o «anuncio» podría no ser suficiente para cumplir con el espíritu de la norma si el resto de la respuesta está redactada de tal forma que induce a confusión. La LGP busca evitar precisamente esto: que el consumidor no sea consciente de que está siendo expuesto a un mensaje persuasivo con una finalidad comercial. La capacidad de ChatGPT para generar texto contextualizado y coherente convierte la publicidad encubierta en un riesgo sistémico.

Asimismo, la LGP prohíbe en su artículo 3 diversas formas de publicidad ilícita que adquieren una nueva dimensión en el contexto de la IA. La publicidad engañosa, definida como aquella que induce o puede inducir a error a sus destinatarios, podría manifestarse si ChatGPT presenta un producto o servicio como la mejor opción objetiva, basándose en un sesgo comercial oculto. La publicidad desleal, por su parte, se solapa con la Ley de Competencia Desleal y abarca prácticas como la denigración o la comparación no objetiva. Finalmente, la publicidad subliminal, definida como aquella que «mediante técnicas de producción de estímulos de intensidades fronterizas con los umbrales de los sentidos o análogas, pueda actuar sobre el público destinatario sin ser conscientemente percibida», encuentra en la IA un vehículo de una potencia inédita. Un sistema capaz de analizar el estado de ánimo de un usuario a través de su conversación podría, teóricamente, insertar mensajes publicitarios diseñados para explotar esa vulnerabilidad emocional, actuando en un plano que roza la manipulación subconsciente.

(Imagen: Pablo Sáez Hurtado)

Ley 34/2002, de 11 de julio, de Servicios de la Sociedad de la Información y de Comercio Electrónico (LSSI-CE)

La LSSI-CE es directamente aplicable a OpenAI, en tanto que presta un servicio de la sociedad de la información a cambio de una contraprestación (ya sea directa, en los planes de pago, o indirecta, a través de la monetización de los usuarios gratuitos). Su artículo 20 refuerza el principio de identificación de la LGP, exigiendo que «las comunicaciones comerciales realizadas por vía electrónica deberán ser claramente identificables como tales». Además, obliga a que se especifique la persona física o jurídica en nombre de la cual se realizan. Para OpenAI, esto implica no solo etiquetar el contenido como publicitario, sino también identificar claramente al anunciante final, una obligación que puede resultar compleja en el ecosistema de la publicidad programática.

El artículo 22 de la LSSI-CE, que regula el uso de «cookies» y otros dispositivos de almacenamiento y recuperación de datos, es de una relevancia capital. Aunque la norma se asocia comúnmente a la navegación web, su redacción es tecnológicamente neutral y se aplica a cualquier dispositivo terminal del usuario. Si OpenAI utiliza información del dispositivo del usuario o de sus interacciones pasadas para personalizar la publicidad, necesitará obtener un consentimiento previo, informado y expreso. La gestión de este consentimiento en una interfaz conversacional, sin recurrir a los manidos (y a menudo ineficaces) banners de cookies, representa un desafío de diseño y de cumplimiento normativo considerable.

Ley 3/1991, de 10 de enero, de Competencia Desleal (LCD)

La LCD protege los intereses de los competidores y de los consumidores frente a prácticas contrarias a la buena fe. La introducción de publicidad en ChatGPT abre la puerta a múltiples actos de competencia desleal. El más evidente es la publicidad encubierta, considerada una práctica desleal por engañosa en su artículo 26. Este artículo considera desleal «la inclusión como información en un medio de comunicación, de materias que respondan a una finalidad publicitaria o de promoción, sin que se advierta de forma clara y perceptible que se trata de un contenido publicitario». Si ChatGPT presenta un producto dentro de una respuesta informativa sin una clara advertencia, estaría incurriendo en una práctica ilícita que podría ser perseguida tanto por competidores como por asociaciones de consumidores.

Los actos de engaño (artículo 5) y las omisiones engañosas (artículo 7) también son pertinentes. Se consideraría un acto de engaño si ChatGPT atribuye a un producto características falsas o induce a error sobre su naturaleza. Más sutilmente, una omisión engañosa podría ocurrir si, al ser preguntado por las mejores opciones para una determinada necesidad, el sistema omite deliberadamente a competidores del anunciante, presentando una visión sesgada del mercado como si fuera una evaluación objetiva y completa.

Real Decreto Legislativo 1/2007, de 16 de noviembre, por el que se aprueba el texto refundido de la Ley General para la Defensa de los Consumidores y Usuarios (LGDCU)

Desde la perspectiva del consumidor, la LGDCU es un baluarte fundamental. Su artículo 8 consagra el derecho a una «información veraz, eficaz y suficiente sobre las características esenciales de los bienes y servicios». Este derecho se ve directamente amenazado si la información proporcionada por ChatGPT está contaminada por intereses comerciales no declarados. La confianza que el usuario deposita en la aparente objetividad de la IA hace que el riesgo de vulneración sea especialmente elevado.

Además, los términos y condiciones de uso de ChatGPT deberán ser examinados a la luz de la normativa sobre cláusulas abusivas. Si OpenAI intentara, por ejemplo, eludir su responsabilidad por la publicidad engañosa generada por su sistema a través de cláusulas de exoneración genéricas, estas podrían ser declaradas nulas por abusivas, conforme a lo dispuesto en los artículos 80 y siguientes de la LGDCU. La naturaleza del servicio, un «diálogo» con una máquina, no exime a OpenAI de sus responsabilidades como proveedor de un servicio a consumidores.

(Imagen: Pablo Sáez Hurtado)

Ley Orgánica 3/2018, de 5 de diciembre, de Protección de Datos Personales y garantía de los derechos digitales (LOPDGDD)

Finalmente, la LOPDGDD, que adapta el ordenamiento español al Reglamento General de Protección de Datos (RGPD), impone límites estrictos al tratamiento de datos personales con fines publicitarios. La base jurídica para la publicidad personalizada es, inequívocamente, el consentimiento del interesado. OpenAI no podrá ampararse en un hipotético «interés legítimo» para analizar el contenido de las conversaciones de los usuarios y mostrarles anuncios basados en ellas. Deberá obtener un consentimiento libre, específico, informado e inequívoco para dicho fin.

La protección de los menores de edad es especialmente relevante. El artículo 92 de la LOPDGDD prohíbe expresamente a los responsables de servicios de la sociedad de la información dirigidos a menores de 14 años recabar su consentimiento para el tratamiento de sus datos con fines publicitarios. Dado que ChatGPT es una herramienta de acceso general, OpenAI deberá implementar mecanismos robustos y eficaces de verificación de la edad, una tarea notoriamente compleja en el entorno digital, para evitar incurrir en una infracción grave. La simple declaración del usuario es, a todas luces, insuficiente.

Marco jurídico europeo: el corsé regulatorio de la Unión Europea

Si el marco normativo español ya plantea un campo de minas para el modelo publicitario de OpenAI, la legislación europea añade una capa de complejidad aún mayor. Bruselas ha desplegado en los últimos años un arsenal regulatorio sin precedentes para gobernar el entorno digital, y ChatGPT, como plataforma de alcance global, se encuentra en el epicentro de esta nueva ola regulatoria. El Reglamento de Servicios Digitales (DSA), el Reglamento de Inteligencia Artificial (AI Act) y la normativa de privacidad conforman un corsé jurídico que constriñe significativamente las ambiciones comerciales de OpenAI en el continente.

V.1. Reglamento (UE) 2022/2065, de Servicios Digitales (DSA)

Designada como «Plataforma en Línea de Muy Gran Tamaño» (VLOP, por sus siglas en inglés) debido a su masivo número de usuarios en la Unión Europea, OpenAI se ve sometida a las obligaciones más estrictas del DSA. En materia de publicidad, el reglamento es taxativo. El artículo 26 impone una transparencia radical: por cada anuncio que muestre, ChatGPT deberá informar en tiempo real y de forma clara, concisa y no ambigua sobre: (i) que la información es publicidad; (ii) la persona física o jurídica en cuyo nombre se presenta; (iii) la persona física o jurídica que ha pagado por el anuncio (si es diferente); y (iv) los principales parámetros utilizados para determinar el destinatario del anuncio y, en su caso, cómo modificarlos.

Esta última exigencia es particularmente disruptiva. Si ChatGPT personaliza un anuncio basándose en la conversación actual del usuario (por ejemplo, porque ha mencionado su interés en viajar a Italia), deberá explicarlo. Esto obliga a OpenAI a desvelar, al menos parcialmente, la lógica de sus algoritmos de segmentación, un activo que las empresas tecnológicas suelen guardar con celo como secreto comercial.

Además, el artículo 28 del DSA prohíbe de forma absoluta la presentación de publicidad basada en la elaboración de perfiles (utilizando datos personales) cuando el servicio se dirige a menores o cuando se utilizan categorías especiales de datos, como la salud, la orientación sexual o las opiniones políticas. Dado que las conversaciones con ChatGPT pueden versar sobre cualquiera de estos temas sensibles, OpenAI se enfrenta a un dilema mayúsculo: o bien implementa un sistema de monitorización de contenido en tiempo real para evitar mostrar publicidad contextual en conversaciones «sensibles» (lo que plantea a su vez enormes problemas de privacidad), o bien renuncia a la publicidad personalizada basada en el contenido de la conversación, limitándose a anuncios genéricos o contextuales no basados en datos personales.

Finalmente, el artículo 25 prohíbe los llamados «patrones oscuros» (dark patterns), definidos como interfaces diseñadas para engañar o manipular a los usuarios e impedirles tomar decisiones autónomas y con conocimiento de causa. Cualquier intento de ofuscar la naturaleza publicitaria de un contenido, o de dificultar la desactivación de la personalización, sería considerado un patrón oscuro y, por tanto, una infracción del DSA.

(Imagen: Pablo Sáez Hurtado)

V.2. Reglamento (UE) 2024/1689, de Inteligencia Artificial (AI Act)

El AI Act, la primera ley integral sobre inteligencia artificial del mundo, clasifica los sistemas de IA en función de su riesgo. Si bien un chatbot de propósito general como ChatGPT no es considerado de «alto riesgo» en su totalidad, sí lo son algunos de sus posibles usos, y el propio modelo está sujeto a obligaciones específicas. La introducción de publicidad activa varias de las disposiciones más críticas del reglamento.

El artículo 5 prohíbe ciertas prácticas de IA por considerarlas inaceptables. Entre ellas, se encuentra «la introducción en el mercado, la puesta en servicio o la utilización de un sistema de IA que utilice componentes subliminales que transciendan la conciencia humana o técnicas deliberadamente manipuladoras o engañosas, con el objetivo o al efecto de alterar de manera sustancial el comportamiento de una persona». La publicidad conversacional, por su propia naturaleza, coquetea peligrosamente con esta línea roja. Un sistema que aprende del usuario y adapta su lenguaje para maximizar la persuasión podría ser considerado, sin mucho esfuerzo interpretativo, como una forma de manipulación.

Las obligaciones de transparencia del artículo 50 son igualmente cruciales. Este precepto exige que los sistemas de IA destinados a interactuar con personas físicas sean diseñados de forma que estas sean informadas de que están interactuando con una IA. Más importante aún, establece que los sistemas que generen contenido de imagen, audio o vídeo que se asemeje a personas o hechos existentes («ultrafalsificaciones» o deepfakes) deben revelar que el contenido ha sido generado o manipulado artificialmente. Si ChatGPT se utiliza para crear anuncios en formato de audio o vídeo, esta obligación de divulgación será de aplicación directa.

Como proveedor de un modelo de IA de propósito general (General-Purpose AI Model), OpenAI también debe cumplir con las obligaciones del Título IV del Reglamento, como la elaboración de una documentación técnica detallada, la publicación de un resumen sobre el contenido utilizado para el entrenamiento y el cumplimiento de la legislación de la UE sobre derechos de autor. La monetización a través de la publicidad refuerza la necesidad de un cumplimiento estricto de estas obligaciones, ya que el modelo deja de ser un mero experimento de investigación para convertirse en el motor de una operación comercial a gran escala.

V. 3. Directiva 2002/58/CE (ePrivacy) y RGPD

La Directiva ePrivacy (y su futura sucesora, el Reglamento ePrivacy, aún en negociación) regula la confidencialidad de las comunicaciones electrónicas. Su artículo 5.1 exige el consentimiento del usuario para almacenar información o acceder a la información almacenada en su equipo terminal. Como se mencionó anteriormente, esto es directamente aplicable a cualquier forma de seguimiento o personalización publicitaria. Pero, además, el contenido de las conversaciones con ChatGPT podría ser considerado «contenido de una comunicación electrónica», cuya confidencialidad está protegida. Analizar dicho contenido con fines publicitarios, incluso de forma automatizada, podría ser interpretado como una interceptación ilegal si no se cuenta con el consentimiento explícito e informado de todos los usuarios implicados en la comunicación.

El RGPD, por su parte, sigue siendo la norma fundamental para cualquier tratamiento de datos personales. La base del consentimiento, la evaluación de impacto relativa a la protección de datos (EIPD) que OpenAI deberá realizar, y los derechos de los interesados (acceso, rectificación, supresión, portabilidad) son plenamente aplicables. La escala masiva del tratamiento de datos que implica la publicidad personalizada en ChatGPT convierte a OpenAI en un objetivo prioritario para las autoridades de protección de datos europeas, que sin duda examinarán con lupa cada aspecto de su modelo de negocio.

V.4. Directiva (UE) 2024/2853, de Responsabilidad por Productos Defectuosos

Esta nueva directiva, que moderniza el régimen de responsabilidad civil por productos, es de una importancia capital. Por primera vez, incluye explícitamente el software y los sistemas de IA en la definición de «producto». Esto significa que OpenAI, como fabricante de ChatGPT, puede ser considerado responsable bajo un régimen de responsabilidad objetiva (sin necesidad de probar la culpa) por los daños que cause un «defecto» en su producto.

Un producto es defectuoso si no ofrece la seguridad que cabría legítimamente esperar. En el contexto de la publicidad, esto abre un nuevo frente de responsabilidad. Si ChatGPT genera un anuncio que contiene información falsa sobre un producto (por ejemplo, sobre sus propiedades curativas) y un usuario sufre un daño como consecuencia de haber confiado en esa información, podría reclamar una indemnización directamente a OpenAI. La defensa de que el contenido fue proporcionado por un tercero (el anunciante) podría no ser suficiente para exonerar a OpenAI, ya que es su sistema el que ha «fabricado» la respuesta final. Esta directiva traslada una parte significativa del riesgo publicitario desde el anunciante hasta la plataforma tecnológica, una consecuencia que podría tener un profundo impacto en la viabilidad económica del modelo publicitario de la IA.

(Imagen: Pablo Sáez Hurtado)

Zonas grises y conflictos normativos

La aplicación de un marco jurídico concebido para un mundo predigital a una tecnología tan novedosa como la IA conversacional genera inevitablemente un sinfín de zonas grises y conflictos interpretativos. La estrategia publicitaria de OpenAI se adentra en un territorio legal pantanoso, donde las viejas distinciones se difuminan y surgen nuevos desafíos que ponen a prueba la resiliencia de la ley.

La principal de estas zonas grises es la difícil distinción entre una respuesta orgánica y un anuncio. OpenAI promete etiquetar claramente la publicidad, pero la realidad es mucho más compleja. ¿Qué ocurre si un usuario pregunta por «el mejor restaurante italiano de Madrid» y ChatGPT, en lugar de mostrar un banner, responde con un párrafo elocuente describiendo las virtudes de un restaurante que ha pagado por aparecer en primer lugar? Aunque la respuesta esté precedida por una etiqueta de «patrocinado», la redacción persuasiva y contextualizada, generada por la propia IA, desdibuja la frontera entre contenido editorial y publicitario. El formato conversacional crea un «efecto halo» donde la credibilidad de la IA se transfiere al contenido promocional, un fenómeno que la legislación actual no ha previsto y para el que no tiene una respuesta clara.

La atribución de responsabilidad es otro campo de batalla jurídico. Si ChatGPT genera un anuncio engañoso o difamatorio, ¿quién es el responsable último? ¿Es OpenAI, como proveedor de la tecnología que ha generado el mensaje? ¿Es el anunciante, que ha proporcionado los parámetros iniciales para la campaña? ¿O es la propia IA, como agente autónomo (una ficción jurídica que el derecho aún no contempla)? La nueva Directiva de Productos Defectuosos apunta hacia OpenAI, pero la cadena de la publicidad programática es tan compleja que deslindar las responsabilidades será una tarea titánica para los tribunales. Es previsible una oleada de litigios que buscarán establecer los límites de la responsabilidad en esta nueva era de la publicidad algorítmica.

La verificación de la edad y la protección de los menores representan un desafío técnico y legal casi insuperable. El DSA y la LOPDGDD prohíben la publicidad perfilada a menores, pero ¿cómo puede OpenAI garantizar de forma fehaciente que un usuario no es menor de edad? Los sistemas de autodeclaración son notoriamente ineficaces. Cualquier método de verificación más robusto (como la solicitud de un documento de identidad o el uso de sistemas de estimación de edad basados en biometría) chocaría frontalmente con los principios de minimización de datos y privacidad desde el diseño. OpenAI se encuentra en una encrucijada regulatoria: o incumple las normas de protección de menores o implementa sistemas de vigilancia que son, en sí mismos, problemáticos desde el punto de vista de la privacidad.

Finalmente, la propia naturaleza de la publicidad contextual basada en conversaciones privadas plantea una tensión fundamental con el derecho a la intimidad y la confidencialidad de las comunicaciones. Aunque OpenAI se comprometa a no «vender» los datos, el mero hecho de analizar el contenido de una conversación en tiempo real para insertar un anuncio relevante es una forma de tratamiento de datos de una intensidad sin precedentes. Los usuarios pueden estar revelando información personal extremadamente sensible (problemas de salud, dificultades financieras, crisis personales) que, aunque no se comparta con terceros, se utiliza para un fin comercial. La validez del consentimiento otorgado para este tipo de análisis en el marco de una relación de confianza con un «asistente» personal es altamente cuestionable.

Conclusiones: el espejo de Dorian Gray se resquebraja

El anuncio de la introducción de publicidad en ChatGPT no es una mera actualización de producto; es la demolición controlada del mito fundacional de OpenAI. La promesa de una inteligencia artificial neutral, un oráculo del conocimiento puro al servicio de la humanidad, se ha revelado como una utopía insostenible, devorada por la implacable lógica económica que gobierna el universo digital. El espejo de Dorian Gray, que durante años ha reflejado una imagen de altruismo y progreso científico, finalmente se ha resquebrajado, mostrando la verdadera naturaleza de un modelo de negocio que, en esencia, no es diferente del de Google o Meta: la atención del usuario es el producto, y la publicidad es el motor.

Las implicaciones de esta transformación son profundas. En primer lugar, la confianza en los sistemas de IA de propósito general queda herida de muerte. Si el asistente conversacional más avanzado del mundo puede ser influenciado por intereses comerciales, ¿cómo podemos fiarnos de la objetividad de sus respuestas? La contaminación publicitaria degrada la herramienta, convirtiéndola de una potencial biblioteca de Alejandría digital a un gigantesco y sofisticado folleto publicitario. La «democratización del conocimiento» se convierte en una «democratización del marketing».

En segundo lugar, la decisión de OpenAI evidencia la necesidad urgente de una adaptación regulatoria. El marco jurídico actual, tanto español como europeo, ofrece herramientas para combatir los excesos más flagrantes, pero no está diseñado para afrontar los desafíos sutiles y sistémicos de la publicidad conversacional. La distinción entre contenido orgánico y patrocinado, la atribución de responsabilidad algorítmica y la protección de la vulnerabilidad emocional del usuario en un diálogo con una máquina son cuestiones que exigen una reflexión legislativa más profunda y específica.

Finalmente, la historia de ChatGPT y la publicidad nos devuelve a una lección que la economía digital nos ha enseñado una y otra vez: si no pagas por el producto, tú eres el producto. No hay nada nuevo bajo el sol. La inteligencia artificial, a pesar de su aura de novedad y su potencial transformador, no es inmune a las fuerzas del mercado. El pacto fáustico de Silicon Valley exige un precio, y ese precio es, casi siempre, la privacidad y la autonomía del usuario. El retrato de Dorian Gray ya no está oculto. Lo tenemos delante, y nos devuelve el reflejo de una sociedad que, en su búsqueda de la comodidad y el acceso instantáneo a la información, está dispuesta a aceptar que incluso sus conversaciones más íntimas se conviertan en una oportunidad para venderle algo. Ja!