Moisés Barrio: “Es falso que la regulación legal acabe con la innovación”

Los expertos aplauden el trabajo regulatorio de la UE, aunque observan ciertas lagunas

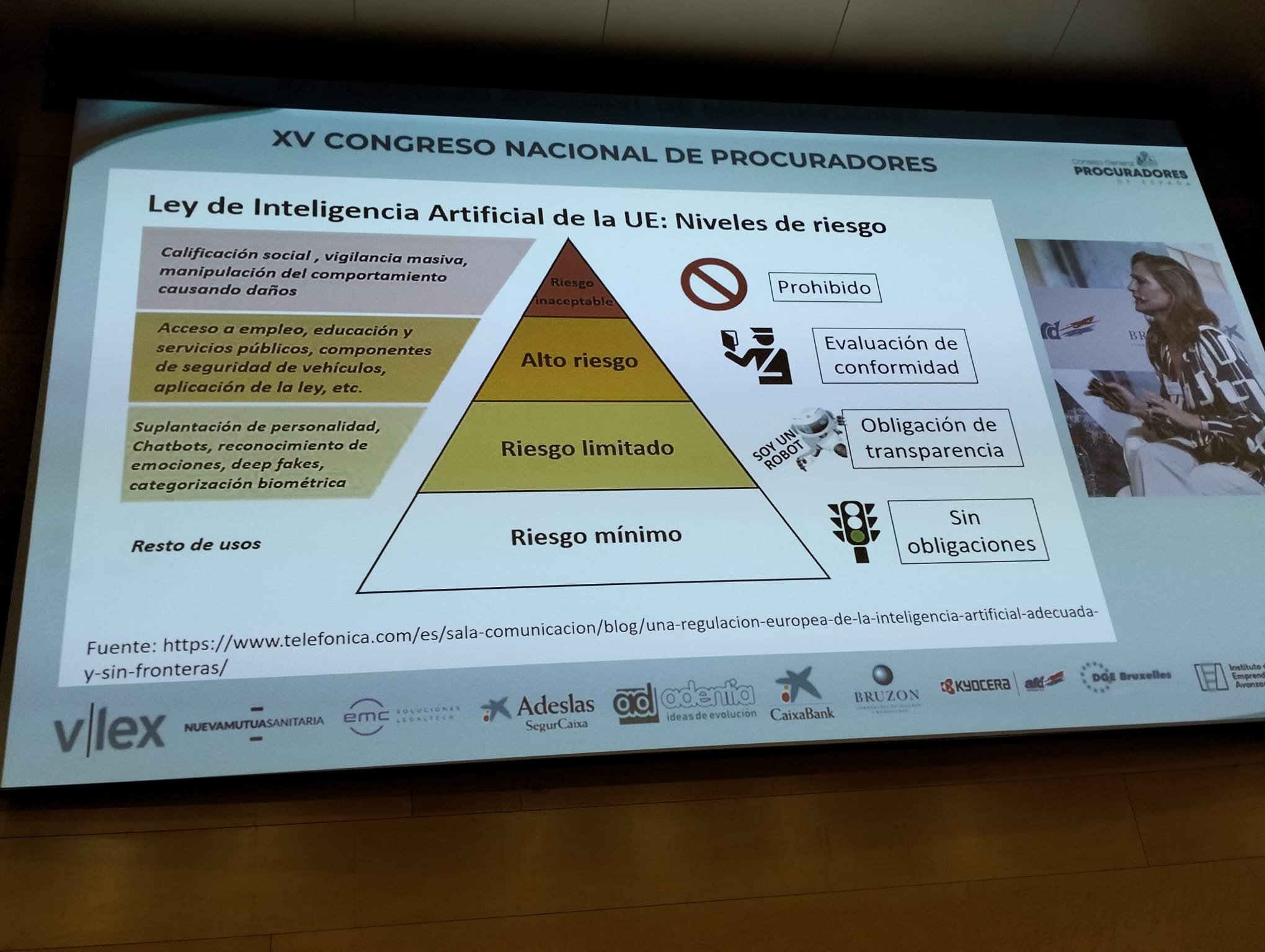

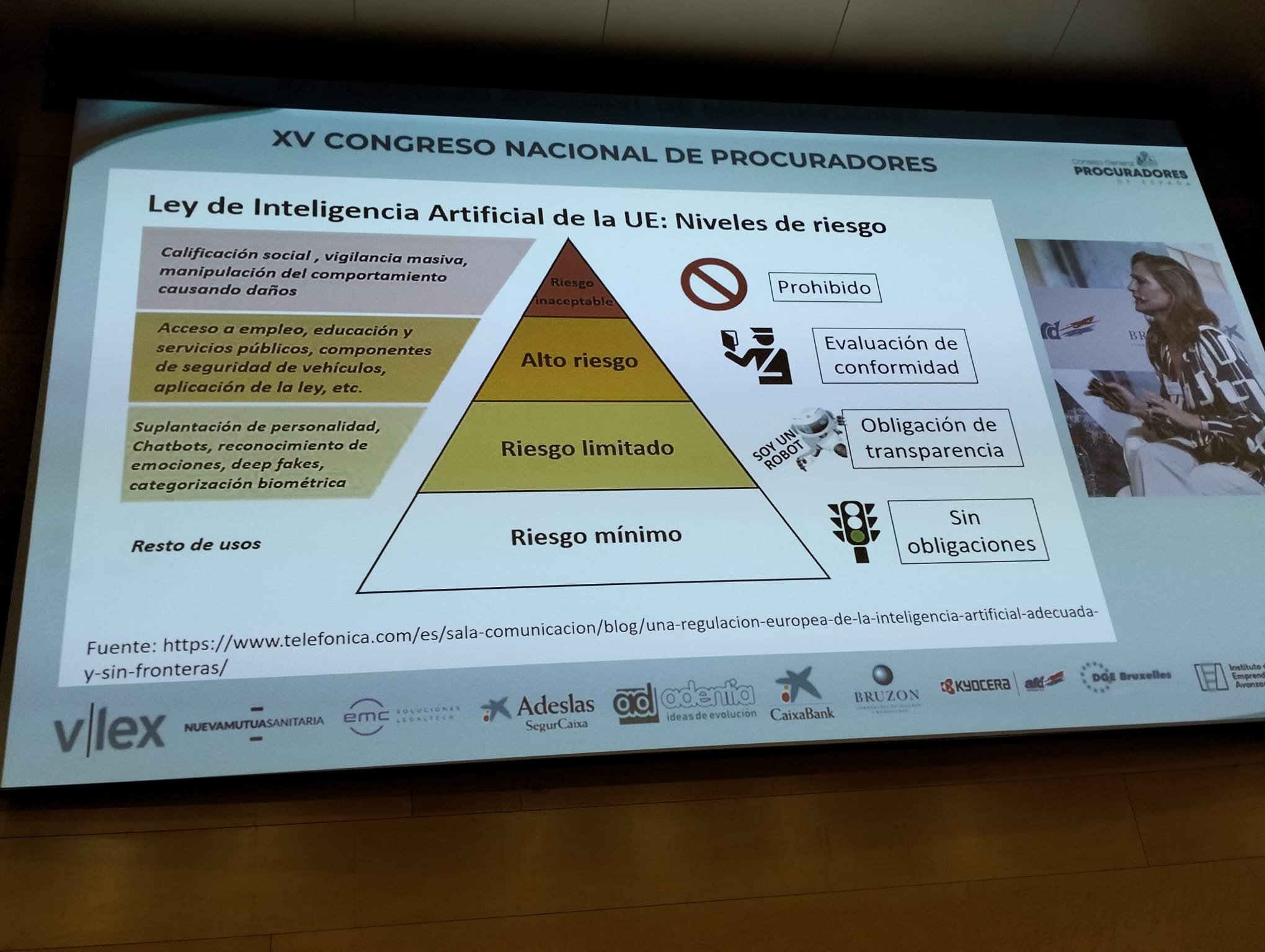

La clasificación de riesgos de la IA. (Imagen: E&J)

Moisés Barrio: “Es falso que la regulación legal acabe con la innovación”

Los expertos aplauden el trabajo regulatorio de la UE, aunque observan ciertas lagunas

La clasificación de riesgos de la IA. (Imagen: E&J)

“La causa de que no tengamos gigantes tecnológicos en Europa no es la regulación. Es falso de toda falsedad que la regulación mate a la innovación”, afirma Moisés Barrio. El letrado del Consejo de Estado, profesor de Derecho digital y asesor de diversos Estados en regulación digital se ha referido así a la propuesta de reglamento para que el desarrollo de la IA se atenga a determinadas normas en el Congreso Nacional de Procuradores, que se clausura esta mañana en Granada tras tres días de intensa actividad.

Barrio sostiene que nos encontramos en una época de confusión tecnológica y que la IA no es realmente algo nuevo, sino que sus bases se asentaron hace más de medio siglo. La diferencia ahora es el potencial de la IA, pues tiene una capacidad ilimitada de procesamiento y almacenamiento de información y tenemos a nuestra disposición un enorme volumen de datos. Esto hace imprescindible su regulación. “En Europa hasta 2018 (RGPD) había dos normas muy exiguas y no éramos un gigante tecnológico. Por tanto, no es culpa de la regulación. Es más, la regulación en la industria de las telecomunicaciones la ha impulsado”, ha afirmado.

En este sentido, ha elogiado el esfuerzo que se ha hecho en la UE para desarrollar un reglamento, cuyas normas ya se prueban en un entorno controlado, conocido como SandBox, y que cataloga los riesgos que puede entrañar la IA en diferentes categorías.

Así, ha explicado que hay utilizaciones prohibidas como la manipulación del comportamiento o la vigilancia masiva; hay usos de alto riesgo como serán aquellos que afecten al acceso a empleo, educación y servicios públicos, aplicación de la ley o los relativos a la seguridad de vehículos. Entre las de riesgo limitado, en un escalón inferior, se encuentran aquellas aplicaciones de la IA que sirvan como chatbots, que puedan reconocer emociones o generar noticias falsas. El resto de los usos serán de riesgo mínimo.

La cuestión, apunta la catedrática de Derecho Civil de la Universidad de Cádiz, Margarita Castilla, es qué metemos en cada uno de los cajones o categorías descritos y quien y bajo qué parámetros se decide el criterio a seguir para esta clasificación. Así, las noticias falsas, consideradas de riesgo limitado, pueden tener un efecto desastroso dado que generan desinformación, pueden desacreditar a personas, influir en la opinión pública, manipular mercados financieros e incluso desestabilizar relaciones internacionales.

Esta jurista considera que “es necesario un marco jurídico de responsabilidad civil en materia de IA porque los ordenamientos nacionales actualmente vigentes no sirven para dar respuesta a las reclamaciones por daños provocados por productos de la IA. De esta manera, incrementaríamos la seguridad jurídica y daríamos vias a los damnificados para reclamar. Al tiempo, se incrementa la confianza, se protege el derecho a tutela judicial efectiva, y la responsabilidad puede funcionar como incentivo empresarial”.

En este marco, la propuesta de directiva revisada de responsabilidad civil por daños producidos por productos defectuosos podría ser aplicable, aunque las normas que contiene no son exclusivas para la IA. Contempla como responsable al fabricante y como víctima a una persona física particular; los daños que aparecen en la norma pueden ser a la salud, a los bienes, por pérdida de datos o pérdidas materiales por razón de pérdida de vidas humanas y el criterio de imputación es objetivo.

En cambio, la propuesta de directiva relativa a la adaptación de las normas de responsabilidad civil extracontractual a la IA va más allá. Sus normas son de aplicación exclusiva para la IA, el responsable puede extenderse a cualquier persona que influya en el sistema de IA y la víctima cualquier persona física o jurídica damnificada. Se incluyen como indemnizables cualquier tipo de daños y perjuicios cubiertos por la ley nacional, así como los daños derivados de discriminación, pérdida de privacidad o violación de otros derechos fundamentales.